Java网络爬虫实现方法及框架选择指南

创始人

2024-12-18 00:05:38

0 次浏览

0 评论

Java网络爬虫怎么实现?

网络爬虫是一种自动从万维网上下载网页供搜索引擎使用的程序,是搜索引擎的重要组成部分。传统的爬虫从一个或多个初始网页的URL出发,获取初始网页上的URL。

在抓取网页的过程中,它不断地从当前页面中提取新的URL并将其放入队列中,直到确定为止。

满足系统的停止条件。

对于垂直搜索来说,聚焦爬虫,即针对特定主题有针对性地抓取网页的爬虫,是比较合适的。

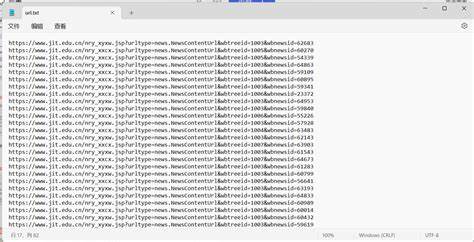

下面是一个简单的Java实现的爬虫核心代码:publicvoidcrawl()throwsThrowable{while(continueCrawling()){CrawlerUrlurl=getNextUrl();//获取队列中下一个要爬取的URLif(url!=null){printCrawlInfo();Stringcontent=getContent(url);//获取URL的文字信息//焦点爬虫只爬取对应内容的网页,这里使用正则匹配进行简单处理if(isContentRelevant(content,this.regexpSearchPattern)){saveContent(url,content);//保存网页到本地//获取网页内容中的链接放入抓取的队列CollectionurlStrings=extractUrls(content,url);addUrlsToUrlQueue(url,urlStrings);}else{System.out.println(url+"isnotrelevantignoring...");}//延迟防止被对方阻塞Thread.sleep(this.delayBetweenUrls);}}closeOutputStream();}privateCrawlerUrlgetNextUrl()throwsThrowable{CrawlerUrlnextUrl=null;while((nextUrl==null)&&(!urlQueue.isEmpty())){CrawlerUrlcrawlerUrl=this.urlQueue.remove();//doWeHavePermissionToVisit:是否有权限访问该URL,友好的爬虫提供的网站爬取配置规则将基于“robot.txt”//isUrlAlreadyVisited:URL是否已被访问。

大型搜索引擎通常使用布隆过滤器进行重复数据删除。

这里我们简单的使用HashMap//isDepthAcceptable:已达到指定的深度限制。

爬虫通常采用广度优先的方法。

有些网站会创建爬虫陷阱(自动生成一些无效链接,让爬虫陷入死循环)并使用深度限制来避免if(doWeHavePermissionToVisit(crawlerUrl)&&(!isUrlAlreadyVisited(crawlerUrl))&&is。

DepthAcceptable(crawlerUrl)){nextUrl=crawlerUrl;//System.out.println('Nexturltobevisitedis'+nextUrl);}}returnnextUrl;}privateStringgetContent(CrawlerUrlurl)throwsThrowable{//HttpClient4.1的调用与之前不同方法HttpClientclient=newDefaultHttpClient();HttpGethttpGet=newHttpGet(url.getUrlString());StringBufferstrBuf=newStringBuffer();HttpResponseresponse=client.execute(httpGet);if(HttpStatus.SC_OK==response.getStatusLine().getStatusCode()){HttpEntityentity=response.getEntity();if(实体!=null){自助餐redReaderreader=newBufferedReader(newInputStreamReader(entity.getContent(),"UTF-8"));Stringline=null;if(entity.getContentLength()>0){strBuf=newStringBuffer((int)entity.getContentLength());while((line=reader.readLine())!=null){strBuf.append(line).entRelevant(Stringcontent,PatternregexpPattern){booleanretValue=false;if(content!=null){//是否满足正则表达式条件Matcherm=regexpPattern.matcher(content.toLowerCase());retValue=m.find();}returnretValue;}publicListextractUrls(Stringtext,CrawlerUrlcrawlerUrl){MapurlMap=newHashMap();extractHttpUrls(urlMap,text);extractRelativeUrls(urlMap,text,crawlerUrl);returnnewArrayList(urlMap.keySet());}privatevoidextractHttpUrls(MapurlMap,Stringtext){Matcherm=(text);while(m.find()){Stringurl=m.group();String[]terms=url.split('ahref=\'');for(Stringterm:terms){//System.out.println('Term='+term);if(term.startsWith('http')){inindex=Term.indexOf("\"");if(index>0){term=term.substring(0,index);}urlMap.put(term,term);System.out.println("超链接:"+term);}}}}privatevoidextractRelativeUrls(MapurlMap,Stringtext,CrawlerUrlcrawlerUrl){Matcherm=relativeRegexp.matcher(text);URLtextURL=crawlerUrl.getURL();Stringhost=textURL.getHost();while(m.find()){Stringurl=m.group();String[]terms=url.split('ahref=\'');for(Stringterm:terms){if(term.startsWith("/"))){intindex=term.indexOf("\"");if(index>0){term=term.substring(0,index);}strings=//"+host+term;urlMap.put(s,s);System.out.println('Relativeurl:'+s);}}}}publicstaticvoidmain(String[]args){try{Stringurl=''';QueueurlQueue=newLinkedList();Stringregexp='java';你的lQueue.add(newCrawlerUrl(url,0));NaiveCrawlercrawler=newNaiveCrawler(urlQueue,100,5,1000L,regexp);//booleanallowCrawl=crawler.areWeAllowedToVisit(url);//System.out.println("Allowedtocrawl:"+url+""+//allowCrawl);crawler.crawl();}catch(Throwablet){System.out.println(t.toString());t.printStackTrace();}}

java实现网络爬虫用哪个爬虫框架比较好

在开发网络爬虫时,选择正确的框架很重要。常见的爬虫框架大致可以分为三类:1、Nutch等分布式爬虫主要解决大规模URL管理和高速网络爬行的问题。

2、Crawler4j、WebMagic、WebCollector等Java独立爬虫适合独立环境下的爬虫开发。

3、Scrapy等非Java独立爬虫适合非Java环境下的爬虫开发。

分布式爬虫主要适用于大规模数据采集和构建搜索引擎。

不过,作为代表性的去中心化爬虫,对于需要精准数据爬取的用户来说,Nutch可能并不是最佳选择。

原因如下:Nutch主要用于构建搜索引擎,其最初设计并不是为了精确的数据爬取。

该组进程中有三分之二为搜索引擎服务,这使得它们在准确的数据爬行方面有些冗余。

尝试重新开发它以适合精确的数据抓取可能需要完全重写Nutch框架,这在现实生产中是不经济的。

Nutch依赖Hadoop来运行,这会产生额外的开销。

它的爬取速度可能不如单机爬虫快,特别是当你的集群机器数量较少时。

Nutch提供了插件机制,但开发其插件系统的经验有限。

使用反射机制加载和调用插件使程序编写和调试变得复杂。

此外,Nutch没有提供用于精确数据爬取的专用插件挂载点。

大多数插件专注于页面分析,这与准确爬取数据的需求相冲突。

Nutch二次开发所需的开发调试时间远远超过单机爬虫。

理解Nutch源代码的学习成本很高,需要团队成员花费大量的时间来学习。

另外,在调试过程中,可能会出现程序本身之外的各种问题,例如Hadoop或HBase问题。

虽然Nutch2提供了一定的数据持久化功能,但这主要是为了持久化URL信息而不是用户实际需要的结构化数据。

Nutch2当前版本不适合开发。

Nutch2.2.1版本绑定gora-0.3。

对于与HBase一起使用,只能使用较旧的HBase和Hadoop版本。

Nutch2的官方教程具有误导性,可用性较差。

综上所述,如果您不使用搜索引擎,请避免选择Nutch。

如果需要进行精准的数据抓取,可以考虑使用Java独立的爬虫框架,如Crawler4j、WebMagic或WebCollector。

搜索引擎对于项目来说,Nutch1.x是一个不错的选择。

如果您需要使用Nutch2,我们建议等待Nutch2.3发布后再进行开发。

Java爬虫哪个好

最好的Java爬虫是Jsoup和ScrapyJava。

它们广泛应用于网页抓取和数据分析领域,并且功能非常强大且易于使用。

下面对这两个Java爬虫进行详细介绍:

Jsoup简介:

Jsoup是一个开源的Java库,专门用于从网页中提取和操作HTML内容。

它提供了一种通过DOM模型搜索和分析页面元素的简单方法。

Jsoup支持多种网络协议,包括HTTP和HTTPS,可以轻松处理动态加载的网页内容,并且具有良好的容错机制。

此外,它还提供强大的CSS选择器支持,使数据定位和提取变得非常高效和方便。

由于这些优点,Jsoup成为许多开发人员的首选工具。

关于ScrapyJava:

ScrapyJava是一个用Java编写的网络爬虫框架,用于从网站收集数据。

提供灵活易用的API接口,支持网络请求重试、多线程等功能,保证即使在网络不稳定的情况下也能高效记录数据。

ScrapyJava在处理动态页面和数据挖掘方面效果很好。

其集成的中间件系统允许开发人员自定义网络请求、响应处理和其他流程。

另外,ScrapyJava具有良好的扩展性,开发者可以根据自己的需求定制自己的模块和插件。

适用于复杂的数据扫描任务和大规模信息采集项目。

由于其灵活性和高效性,ScrapyJava在爬虫领域也备受推崇。

简而言之,Jsoup和ScrapyJava都是很棒的Java爬虫。

Jsoup适合简单的数据抓取任务和解析HTML内容;而ScrapyJava适合处理动态页面和复杂的数据挖掘任务。

您选择哪种信息收集工具取决于您项目的具体需求和个人喜好。

无论您选择哪种工具,都需要遵守网站的信息收集规则和法律条款,以确保数据的获取和使用合法合规。

相关文章

Java基本数据类型及其占用空间大小解析

2025-01-26 21:15:40

Java文件操作与文件夹创建详解

2025-01-28 17:02:36

百钱买百鸡问题:Python解法与数学探...

2024-12-14 22:21:26

JavaScript字符串截取方法全解析

2025-03-31 16:17:30

Java List转Map:Stream...

2025-01-10 14:54:30

Java与C语言:学习与就业的抉择

2024-12-15 22:51:10

Java CompletableFutu...

2025-03-11 13:17:09

Java项目团队角色解析:关键职责与胜任...

2024-12-17 10:50:13

Python入门:轻松开发小游戏的编程指...

2024-12-25 23:16:38

Java编程:从入门到进阶,精选书籍推荐

2024-12-18 09:26:08最新文章

04

2025-04

04

2025-04

04

2025-04

04

2025-04

04

2025-04

04

2025-04

04

2025-04

04

2025-04

04

2025-04

04

2025-04

热门文章

1

Java字符串分割技巧:轻松获取逗号前的...

java任意一个字符串,当它碰到第一个逗号时,返回逗号前面的字符串,例如:str...

2

SQL多表连接查询全解析:JOIN语句应...

sql多表关联查询在执行SQL多表连接查询时,可以使用JOIN语句将多个表连接在...

3

Java中字符串类型详解:String与...

变量有字符类型,为什么没有字符串类型??基本类型:charshort、int、l...

4

JavaSE与JavaEE:从基础到企业...

javase 和javaee的区别?JavaSE和JavaEE...

5

Java程序员面试必知:核心技术问答与技...

java编程程序员技术面试常见面试?随着互联网的不断发展,Java开发已经成为很...

6

Java.exe与Javaw.exe:区...

程序中java和javaw有什么区别java和javaw的区别:两者都是Java...

7

深入解析:Java中的javax包及其与...

JAVA导入时,什么是javax?awt是java1.0,swing是java2...

8

Java基础教程:深入理解File和Pa...

java中if(!file.exists())什么意思?”“在Java >...

9

Java字符串搜索与位置定位技巧解析

在java中求一个字符串在另一个字符串中多次出现的位置。用indexOf方法怎么...

10

Java静态资源加载机制解析:静态方法与...

java静态资源(静态方法,静态属性)是程序一运行就加载到jvm中,还是当被调用...